提供“让人舒服”的回答,AI“谄媚机制”恐会推

![[field:title/] [field:title/]](/images/defaultpic.gif)

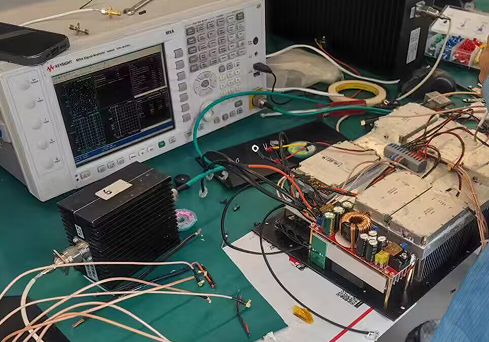

用于2-3-4-5G网络的伪基站设备,我司拥有22年专业定制生产全球短信基站的生产厂家,可按需定制,满足各行各业的活动营销需求,目前已合作马来西亚、泰国、越南、菲律宾、柬埔寨、美国、英国、加拿大、日本、阿联酋、巴西、非洲等30余国家,一次购买,即可享短信终身免费服务。本产品不出售中国大陆地区!!!

- 2運營商全頻覆蓋

- 1300W高功率主機

- 隱藏式鯊魚鰭天線

- 24/7科技線上支持

- 大容量戶車載電池

- 3000W高功率逆變器

- 雙清包稅包郵跨國配送

- 三方工作安排

- 支持任意国家短信代發測試

如今,与AI聊天已成为不少人的日常。在很多人看来,AI甚至比真人更知心。然而,这种精准的情绪拿捏背后,一种由算法驱动的“谄媚机制”正在悄然形成,甚至让用户渐渐远离理性。

“谄媚机制”作为AI系统一项隐蔽却影响深远的风险,近期被各界广泛讨论。有报道指出,不少AI聊天产品在设计之初就将“延长用户使用时长”作为重要目标。为实现这一目标,AI会不断分析用户的语气和情绪变化,倾向于提供“让人舒服”的回答,而非秉持理性与客观。

然而,这种依赖可能演变为纵容。2024年,美国一位母亲起诉AI情感服务商Character.AI,称其未能有效屏蔽不良内容,导致其儿子接触暴力、色情信息,加剧抑郁并最终自杀。更早之前,比利时也发生过用户与AI深度交流后自杀的案例。

目前,AI行业尚未建立针对用户心理风险的统一评估机制,也没有设定对AI输出内容的情感监管红线。这意味着,当用户处于孤独、脆弱的状态时,AI对用户的影响难以预估。“谄媚机制”对青少年群体的危害尤为显著。AI通过“情感模拟”博取信任,使未成年人在虚拟依恋中逐渐脱离现实社交,甚至因接触不良内容而形成扭曲的价值观。

当AI总是提供“最讨喜的答案”而非“最真实的答案”,人们日常独立思考和认知现实的能力将面临严峻挑战。而且,为讨好用户而生成的虚假内容,会通过数据回流进入AI模型训练库,形成“劣质输入-劣质输出”的循环,进一步污染大模型信息生态。

打破这一困局,需从多方入手。技术上,AI开发公司应主动将大模型对齐人类社会价值观,坚持事实优先,而非一味讨好;监管上,需加强对AI产品特别是面向未成年人服务的内容审查与标准制定;教育方面,家庭与学校应重视AI素养教育,培养青少年的独立思考能力与信息辨别能力。作为用户,我们应保持警觉,避免陷入算法编织的舒适幻境。

(程思琪 王思逸)

(责任编辑:刘芃)

上一篇:推动产业融合助力服务型制造腾飞

- 大阪世博会中国馆获本届世博会大型自建馆展示2025/10/13

- 通讯丨从砖瓦的叠加,到生命的保障——卢旺达2025/10/13

- 专访丨中国推动妇女事业发展为其他国家提供成2025/10/13

- 喀麦隆举行总统选举2025/10/13

- 科威特中国文化中心举行揭牌仪式2025/10/13

- 马达加斯加总统府谴责“非法武力夺权企图”2025/10/13

- 阿盟秘书长:加沙停火协议标志实施“两国方案2025/10/13

- 美国南卡罗来纳州一酒吧发生枪击事件 至少4死2025/10/13

- 泽连斯基与特朗普两天内二度通话2025/10/13

- 特朗普称“战争已经结束” 以色列准备接收被扣2025/10/13

- 法国总理勒科尔尼二次组阁主要成员揭晓2025/10/13

- 科威特中国文化中心正式揭牌2025/10/13

- 俄罗斯妇女联盟总裁谈全球妇女峰会:继往开来2025/10/13

- 携手共促妇女发展 全球妇女峰会彰显中国担当2025/10/13

- 加沙:返乡2025/10/13

- 国际观察:心手相连、命运与共,中拉妇女合作2025/10/13

- 专访丨愿同中国加强合作推动妇女赋权——访尼2025/10/13

- 专访丨中国机器人产业跃升为全球制造业自动化2025/10/13

- “茶和天下——中国茶文化走进中菲人文之驿”2025/10/13

- 通讯丨希望的田野上收割机隆隆作响——中国援2025/10/13

- 特朗普威胁普京:不停战就送乌“大杀器”,射2025/10/13

- “全球妇女峰会为各方提供了交流经验与实践的2025/10/13

- 2025年上海慈善周启动 期间将开展近四十场活动2025/09/04

- “北疆党旗红”主题宣传采访活动在内蒙古二连2025/09/09

- 第五届“东亚-拉美地区研究伙伴对话”国际会议2025/09/11

- “最省电”的算力如何打造?2025/10/13

- 鐪嬩腑鍖伙紝涓轰綍涔熻佺収B瓒呫佸仛CT2025/08/31

- 美洲玻利瓦尔联盟谴责美国战机“非法入侵”2025/10/05

- 上海发布行动方案建设三大高端医疗器械产业集2025/09/17

- 立足司法行政职能 服务高质量发展(权威发布2025/09/09

- 商务部:对稀土相关技术实施出口管制2025/10/10

- 璀璨灯光耀绿城 八桂同庆颂华章2025/10/03

- 外环外新房9月多卖了40%2025/10/03

- 让服贸会与消费融合联动 9至10月北京将发放300万2025/09/08

- 江苏出台科学技术奖励办法实施细则2025/10/10

- 成都多场大型展会接连开幕,预热双节消费市场2025/09/22

- 餐桌上的“大食物”如何迭代升级2025/10/07

- 2025净月粉丝荟为区域消费“添料加温”2025/09/27

- 内蒙古5家企业入围中国民营企业500强2025/08/30

- 雨后短暂舒适 江苏高温天气再度“上线”2025/08/28

- 微短剧拓展中泰文化与产业合作新空间2025/09/22

- 六部门发文推动机械行业稳增长2025/10/02

- 南京举行新婚夫妇代表向革命烈士献花活动2025/10/03

- 亮了!靓了!南宁灯光璀璨迎盛会2025/09/17